Welche Nachrichten lese ich? Welche Werbung sehe ich? Bekomme ich den Job? Wie viel kostet meine Versicherung? Welche Behandlung bekomme ich beim Arzt?

Ein kleiner Auszug aus Fragen, die für Bürger*innen in der Schweiz von oder anhand von Algorithmen entschieden werden. Als eine der führenden Nationen im Bereich der Entwicklung von künstlicher Intelligenz, wird sich der Einsatz von algorithmischen Entscheidungssystemen in der Schweiz weiterhin intensivieren. Die KI-Arbeitsgruppe des Bundes sieht künstliche Intelligenz sogar als Grundlagentechnologie für die digitale Transformation der Schweiz (Bundesrat, 2020).

Unweigerlich endet der Einsatz von künstlicher Intelligenz in diesen und anderen sensitiven Lebensbereichen in der Frage: Wie fair oder potentiell diskriminierend sind solche Entscheidungsprozesse? Die allgemeine Befürchtung ist, dass algorithmische Entscheidungssysteme die bestehende Ungleichheit in unserer Gesellschaft abbilden, verstärken oder sogar ganz neue Formen der Diskriminierung schaffen.

Bilden diskriminierende, algorithmische Entscheidungssysteme nur das ab, was sowieso schon da ist?

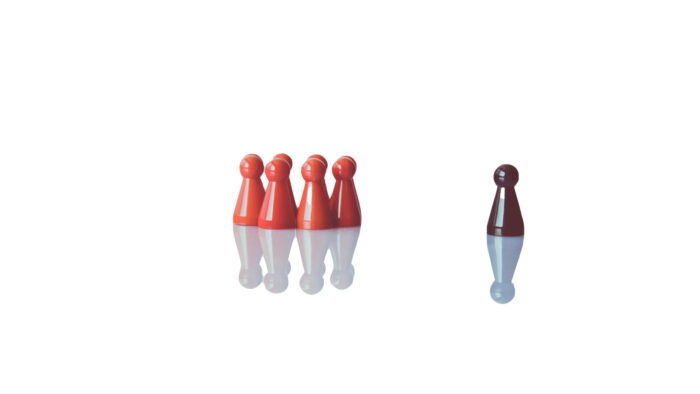

Dieses Phänomen wird Algorithmic Bias genannt. Eine algorithmische Verzerrung liegt vor, wenn bestimmte Personengruppen durch den Algorithmus systematisch benachteiligt werden. Bias kann in algorithmischen Systemen durch die zugrundeliegenden Daten oder beim Design der Software selbst entstehen.

Ein aktuelles Beispiel für Algorithmic Bias aus der Schweiz ist ein gängiger Algorithmus, der die Wahrscheinlichkeit für Nierensteine vorhersagt. Wie viele andere medizinische Prognose-Algorithmen, benötigt er die ethnische Zugehörigkeit des Patienten als Input. Menschen, die in die «non-black» Kategorie fallen, wird automatisch ein höheres Risiko für Nierensteine zugewiesen. Das führt in der Regel zu einer schnelleren und besseren Behandlung. In dieser und ähnlichen medizinischen Situationen kann ein solcher Bias also über Leben und Tod entscheiden.

Auch in der Schweiz: Medizinischer Prognose-Algorithmus benachteiligt People of Colour.

Je tiefer man in das Thema des Algorithmic Bias abtaucht, desto mehr bekommt man die Komplexität des Problems zu spüren. Auf der philosophischen Seite findet ein Diskurs über die «richtige» Definition von Fairness bzw. Diskriminierung statt. Ein Diskurs, der technisch der Unmöglichkeit gegenübersteht, alle theoretischen Auffassungen von Fairness auf einmal zu berücksichtigen, da sie sich teilweise gegenseitig ausschliessen. Auf der technischen Seite sieht man sich mit den Herausforderungen der Blackbox eines komplexen Algorithmus konfrontiert: Was passiert überhaupt alles in meinem Algorithmus?

Währenddessen fällt die Debatte in der Schweiz bis anhin eher karg aus. Dabei sollte die Schweiz vor der Herausforderung, den Einsatz von algorithmischen Entscheidungssystemen und die Algorithmen selber fairer zu gestalten, nicht zurückschrecken. Im Gegenteil stellt dieses vermeintliche Problem des Algorithmic Bias auch eine Chance für die Schweiz dar, sich international als Vorbild zu positionieren.

Das Thema muss die Aufmerksamkeit von Wissenschaft, Politik und Medien erlangen, um den Bürger*innen vor Augen geführt zu werden. Nur so können die wichtigsten nächsten Schritte im Einsatz von Algorithmen und künstlicher Intelligenz angeregt werden. Und dazu zählen nicht nur eine geschulte, aufgeklärte Nutzung von algorithmischen Entscheidungssystemen, sondern auch die Anpassung aktueller Gesetzgebungen.

Es gilt, die Vorteile einer Zukunft mit fairen Algorithmen zu sehen und zu ergreifen. Sei es die Wettbewerbsfähigkeit und Attraktivität des Innovationsstandorts oder die Aufrechterhaltung der Chancengleichheit in der Schweiz. Die Diskussion muss jetzt stattfinden, um handfeste Lösungen zu generieren. Letztendlich können Algorithmen, wenn sie tatsächlich einmal fair sind, uns helfen, unseren eigenen, gesellschaftlichen Bias zu überwinden. Sie können bestehende diskriminierende Praktiken offenlegen und die Reflexion über zugrundeliegende Entscheidungskriterien anstossen. Und darin lohnt es sich frühzeitig zu investieren.

Die Autoren Alexis Perakis, Maya Guido und Amir Mikail leiten das Reatch Projekt «Algorithmic Bias - Building transparency and equality of opportunity in an algorithmic society» im Frühjahrssemester 2021. Sie wollen die Gesellschaft auf die Herausforderungen der Algorithmen-basierten Entscheidungsfindung hinweisen und Lösungsempfehlungen für die Politik ausarbeiten.

Die Beiträge auf dem Reatch-Blog geben die persönliche Meinung der Autor*innen wieder und entsprechen nicht zwingend derjenigen von Reatch oder seiner Mitglieder.

Comments (0)